2023年10月24日,《自然》新闻(Nature News)在线发表了一篇题为"An AI revolution is brewing in medicine. What will it look like?"的特别报道。

Jordan Perchik于2018年开始在亚拉巴马大学伯明翰分校进行放射科住院医生培训,那时正值他所谓的放射科学领域的“AI恐慌”高峰期。在计算机科学家Geoffrey Hinton宣称人们应停止培训成为放射科医生的仅仅两年后,这一时期开始。Hinton被称为人工智能之父,他预测这些系统很快将能够比人类更好地阅读和解释医学扫描图像和X光片。此后,放射科医学项目的申请数量大幅下降。

研究人员正在为机器学习工具提供数百万张医学扫描图像,以赋予它们广泛的诊断能力。(图源:Massimo Brega/Science Photo Library)

研究人员正在为机器学习工具提供数百万张医学扫描图像,以赋予它们广泛的诊断能力。(图源:Massimo Brega/Science Photo Library)

基于人工智能的工具越来越多地成为医疗保健的一部分,美国食品和药品监督管理局(FDA)已经授权使用超过500种这类工具。其中大多数与医学影像有关,用于改进图像质量、测量异常或标记检测结果以供后续跟踪。

调查显示,虽然许多医生知道临床AI工具的存在,但实际上只有很小一部分 (大约在10%到30%之间) 使用过它们,他们的态度从谨慎乐观到彻底不信任不等。荷兰乌得勒支大学医疗中心的医学创新实施专家Charisma Hehakaya说:“一些放射科医生对AI应用的质量和安全性存在疑虑。”即使AI工具能够完成它们的目标任务,仍不清楚这是否会转化为患者更好的医疗护理。

但有一种被称为综合医学AI的方法似乎正在兴起。这些模型受到庞大数据集的训练,就像驱动ChatGPT和其他AI聊天机器人的模型一样。在吸收大量医学图像和文本数据后,这些模型可以适用于许多任务。尽管目前获得批准的工具执行特定功能,比如在计算机断层扫描(CT)中检测肺结节,但这些综合模型将更像医生,评估扫描中的每一种异常情况,并将其整合为一种诊断。

尽管现在的AI爱好者趋向避免大胆宣称机器将取代医生,但许多人认为,这些模型可以克服目前医学AI的某些限制,有朝一日可能在某些情况下超越医生。然而,这些新工具能够在实际临床护理中使用之前,还有漫长的道路需要走。

目前存在的限制

医学领域的人工智能工具充当从业者的辅助角色,例如通过快速浏览扫描图像并标记医生可能立即查看的潜在问题,这些工具有时表现很出色。Jordan Perchik记得有一次,在他值夜班的时候,一种AI分诊工具在凌晨3点为一名出现呼吸急促症状的患者标记了一张胸部CT扫描。他将这张扫描图像提上优先级,并同意AI的评估结果,该结果显示患者存在肺栓塞,这是一种可能致命且需要立即治疗的情况。如果没有被标记出来,这张扫描图像可能要等到当天晚些时候才会被评估。

但如果AI犯了错误,它也会产生相反的效果。Jordan Perchik说,最近他发现了一例AI没有标记出来的肺栓塞病例,他决定采取额外的审查步骤,最终证实了他的评估,但这减缓了他的工作进度。如果他决定相信AI并继续前进,那么这种情况可能会被漏诊。”

许多已获批准的设备并不一定符合医生的需求,早期的AI医学工具是根据影像数据的可用性来开发的,因此一些应用程序是为常见且容易识别的疾病而建立的。

另一个问题是,这些AI工具倾向专注于特定任务,而不是全面解释医学检查——观察图像中可能相关的一切,考虑以前的结果和患者的临床病史。尽管专注于检测一些疾病具有一定价值,但它并不反映放射科医生真正的认知工作。

解决方案通常是增加更多基于AI的工具,但这也对医疗护理构成挑战,伦敦Google Health的临床研究科学家Alan Karthikesalingam表示。假如一个人接受常规乳腺X光检查,技术员可能会采用一种用于乳腺癌筛查的AI工具的辅助。如果发现异常,同一患者可能需要进行磁共振成像(MRI)扫描以确认诊断,而这可能需要另一个AI设备。如果诊断结果得到确认,那么病变将会通过手术移除,可能需要另一种AI系统来协助进行病理学分析。

许多医院并不了解监测AI性能和安全性所涉及的挑战,英国伯明翰大学研究医疗AI负责创新的临床研究员Xiaoxuan Liu表示。她和她的同事们确定了数千份医学成像研究,比较了深度学习模型的诊断性能与医疗保健专业人员的性能。对于该团队评估的69项诊断准确性研究,一个主要发现是,大多数模型未经真正独立于用于训练模型的信息的数据集进行测试。这意味着这些研究可能高估了模型的性能。

坚实的基础

为了解决医学领域AI工具的一些限制,研究人员一直在探索具备更广泛能力的医学人工智能。他们受到了像ChatGPT这样的革命性大型语言模型的启发。这个术语是由斯坦福大学的科学家们在2021年创造的,它描述了在广泛的数据集上进行训练的模型,这些数据集可以包括图像、文本和其他数据,使用一种称为自监督学习的方法。这些基础模型,也被称为基本模型或预训练模型,构成了后续可以适应执行不同任务的基础。

目前大多数医学AI设备是通过监督学习方法开发的。例如,使用这种方法训练一个模型来识别肺炎,需要专家分析大量的胸部X光片并将它们标记为“肺炎”或“非肺炎”,以教导系统识别与该疾病相关的模式。

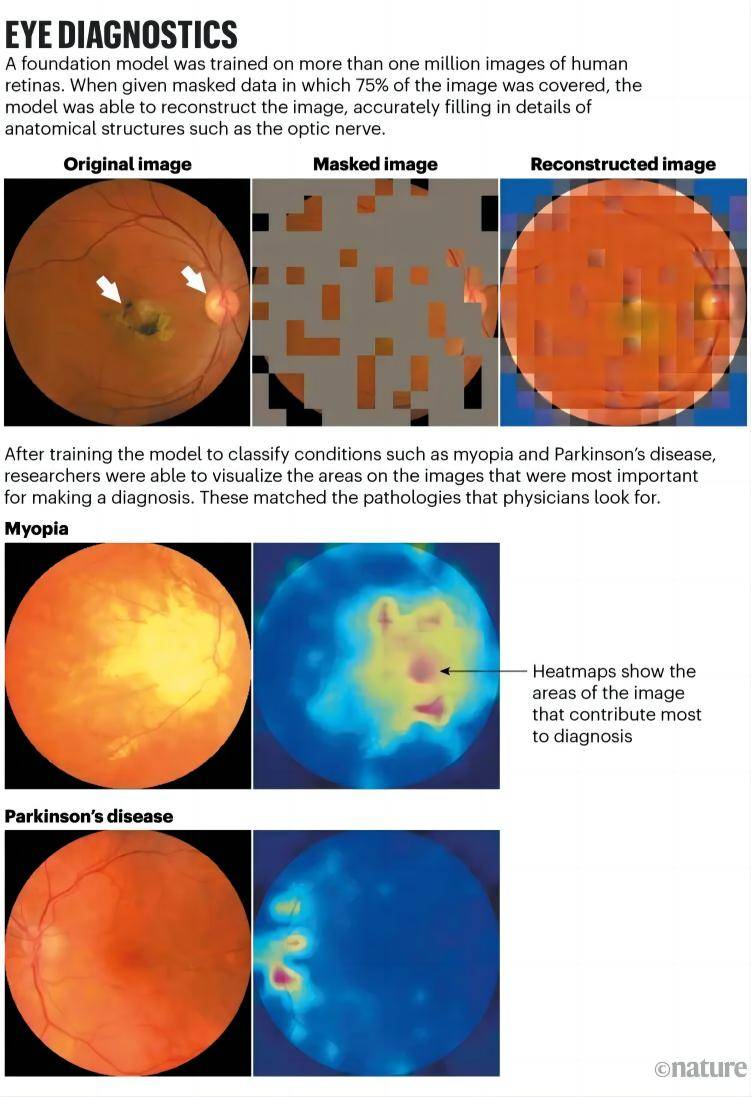

在基础模型中不需要大量图像的注释。例如,对于ChatGPT,使用大量文本进行训练,以训练一个通过预测句子中的下一个单词来学习的语言模型。同样,伦敦摩尔菲尔德眼科医院的眼科医生Pearse Keane及其同事开发的医学基础模型使用了160万张视网膜照片和扫描图像,以学习如何预测这些图像缺失部分应该是什么样子。在进行了这一预训练后,研究人员引入了几百张标记图像,使其能够学习特定的与视觉相关的疾病,如糖尿病性视网膜病变和青光眼。该系统在检测这些眼部疾病以及通过眼底血管微小变化检测出的心脏病和帕金森病等系统性疾病方面优于以前的模型,但该模型尚未在临床环境中进行测试。

图源:https://doi.org/10.1038/s41586-023-06555-x

图源:https://doi.org/10.1038/s41586-023-06555-x

Keane表示,基础模型对眼科学领域特别合适,因为几乎可以对眼部的每个部位进行高分辨率成像。而且有大量的这些图像数据可用于训练这种模型。人工智能将彻底改变医疗保健,而眼科学可以成为其他医学专业的示范。

大型科技公司已经在投资使用多种图像类型的医学成像基础模型,包括皮肤照片、视网膜扫描、X光片和病理学切片,并整合电子健康记录和基因组数据。

今年6月,Google Research科学家们发表了一篇论文,介绍了他们称之为REMEDIS(具有自监督的强大和高效医学成像)的方法,与使用监督学习训练的AI工具相比,该方法能够将诊断准确性提高高达11.5%。研究发现,在对未标记图像的大型数据集进行预训练后,只需要少量标记图像就能达到这些结果。这项研究的共同作者之一,Karthikesalingam说:“我们的主要发现是,REMEDIS能够以非常高效的方式,只需很少的示例,学会如何在许多不同的医学图像中对许多不同的事物进行分类,包括胸部X光片、数字病理学扫描和乳腺X光检查。”

次月,Google的研究人员在一篇预印本中描述了他们如何将这一方法与该公司的医学大型语言模型Med-PaLM相结合,该模型几乎可以像医生一样回答一些开放性的医学问题。结果表明,Med-PaLM Multimodal不仅可以解释胸部X光图像,还可以以自然语言起草医疗报告。

微软也在努力将语言和视觉整合到一个单一的医学AI工具中。今年6月,公司的科学家们推出了LLaVA-Med(生物医学大型语言和视觉助手),该模型在与从PubMed Central(一个公开可访问的生物医学文章数据库)提取的文本配对的图像上进行训练。微软Health Futures的生物医学AI研究负责人Hoifung Poon表示:“一旦你这样做,你就可以开始与图像进行对话,就像你在与ChatGPT交谈一样。” 这种方法的一个挑战是它需要大量的文本-图像对。

随着这些模型在越来越多的数据上进行训练,一些科学家乐观地认为它们可能能够识别人类无法识别的模式。AI工具可能在某些领域超越人类能力,比如使用数字病理学来预测免疫疗法对肿瘤的反应。

Karthikesalingam还指出,即使Google的医学成像AI取得了最佳结果,它仍然无法与人类相媲美。人类放射科医生的X光报告仍然被认为明显优于最先进的多模式综合医学系统。尽管基础模型似乎特别适合扩大医学AI工具的应用,但要展示它们可以安全用于临床护理还有很长的路要走。

毫无疑问,AI在放射科领域的作用将继续增长,与其说取代放射科医生,不如培训他们如何使用AI。

参考资料

原文信息

An AI revolution is brewing in medicine. What will it look like?

DOI

10.1038/d41586-023-03302-0

作者信息

作者:Mariana Lenharo

转载来源

ChemBioAI

排版编辑:肿瘤资讯-Astrid

苏公网安备32059002004080号

苏公网安备32059002004080号